הפונקציה pipeline() היא חלק בלתי נפרד מספריית Transformer. נדרשות מספר כניסות שבהן נוכל להגדיר משימת מסקנות, מודלים, מנגנון טוקניזציה וכו'. פונקציית pipeline() משמשת בעיקר לביצוע משימות NLP על טקסט אחד או כמה טקסטים. הוא מבצע עיבוד מקדים על הקלט ועיבוד לאחר המבוסס על המודל כדי ליצור פלט קריא אנושי וחיזוי מדויק עם דיוק מרבי.

מאמר זה מכסה את ההיבטים הבאים:

מהי ספריית ערכת הנתונים של Hugging Face?

ספריית נתונים של Hugging Face היא ממשק API שמכיל מספר מערכי נתונים ציבוריים ומספק דרך קלה להוריד אותם. ספרייה זו ניתן לייבא ולהתקין לתוך האפליקציה באמצעות ' צִפצוּף ' פקודה. להדגמה מעשית להורדה והתקנת מערכי נתונים של ספריית Hugging Face, בקר כאן קישור לגוגל קולאב. אתה יכול להוריד מערכי נתונים מרובים מה- רכזת ערכת נתונים מחבקת פנים.

למד עוד על תפקוד הפונקציה pipeline() על ידי עיון במאמר זה ' כיצד לנצל את פונקציית Pipeline() בשנאים? '.

כיצד ליישם צינורות על מערך נתונים בחיבוקים?

Hugging Face מספק מספר מערכי נתונים ציבוריים שונים שניתן להתקין בקלות באמצעות קוד בשורה אחת. במאמר זה נראה הדגמה מעשית של יישום צינורות על מערכי נתונים אלה. ישנן שתי דרכים שבהן ניתן ליישם צינורות במערך הנתונים.

שיטה 1: שימוש בשיטת איטרציה

ניתן לבצע איטרציה של הפונקציה pipeline() גם על מערך נתונים ומודל. לשם כך, בצע את השלבים המוזכרים להלן:

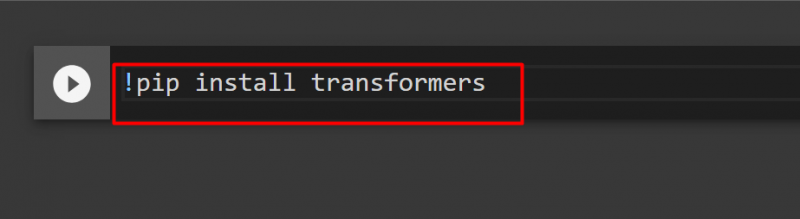

שלב 1: התקן את ספריית Transformer

כדי להתקין את ספריית Transformer, ספק את הפקודה הבאה:

!pip להתקין שנאים

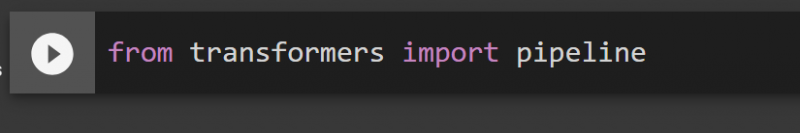

שלב 2: ייבוא צינורות

אנחנו יכולים לייבא את הצינור מספריית הרובוטריק. למטרה זו, ספק את הפקודה הבאה:

מצינור יבוא שנאים

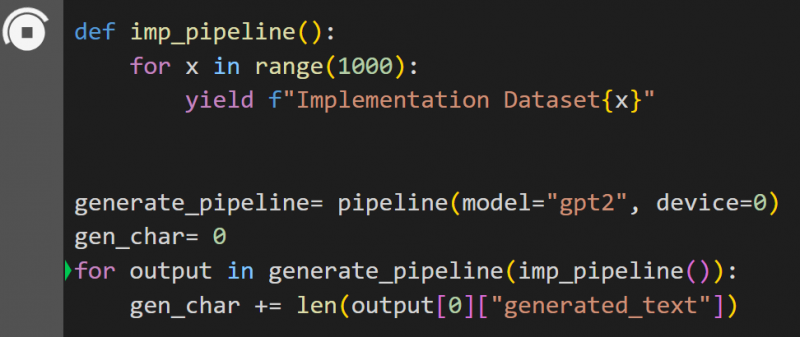

שלב 3: יישום Pipeline

כאן, הפונקציה pipeline() מיושמת במודל ' gpt2 '. אתה יכול להוריד דגמים מה- רכזת דוגמניות מחבקות:

def imp_pipeline():עבור x בטווח (1000):

תשואה f'ערכת נתונים של יישום{x}'

gener_pipeline= pipeline(model='gpt2', device=0)

gen_char= 0

עבור פלט ב-general_pipeline(imp_pipeline()):

gen_char += len(output[0]['generated_text'])

בקוד זה, ' gener_pipeline ' הוא משתנה המכיל את הפונקציה pipeline() עם המודל ' gpt2 '. כשקוראים לזה עם ' imp_pipeline() ', היא מזהה אוטומטית את הנתונים שהוגדלו עם הטווח שצוין ל-1000:

זה ייקח קצת זמן להתאמן. הקישור ל Google Co ניתן גם.

שיטה 2: שימוש בספריית ערכות נתונים

בשיטה זו, נדגים את יישום הצינור באמצעות ספריית 'מערכי הנתונים':

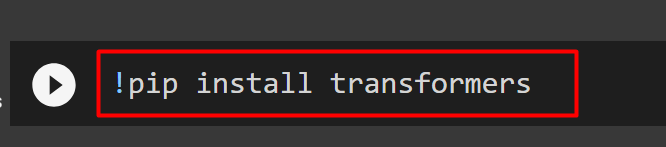

שלב 1: התקן שנאי

כדי להתקין את ספריית Transformer, ספק את הפקודה הבאה:

!pip להתקין שנאים

שלב 2: התקן את ספריית ערכות הנתונים

בתור ' מערכי נתונים 'הספרייה מכילה את כל מערכי הנתונים הציבוריים, אנו יכולים להתקין אותה באמצעות הפקודה הבאה. על ידי התקנת ' מערכי נתונים ', נוכל לייבא ישירות כל מערך נתונים על ידי מתן השם שלו:

!pip התקנת מערכי נתונים

שלב 3: צינור ערכת נתונים

כדי לבנות צינור על מערך הנתונים, השתמש בקוד הבא. KeyDataset הוא תכונה שמוציאה רק את הערכים שמעניינים את המשתמש:

מאת transformers.pipelines.pt_utils ייבוא KeyDatasetמצינור יבוא שנאים

ממערכי נתונים ייבוא load_dataset

gen_pipeline = pipeline(model='hf-internal-testing/tiny-random-wav2vec2', device=0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]')לפלט ב-gen_pipeline(KeyDataset(loaddataset, 'audio')):

print('הדפסת פלט עכשיו')

הדפס ('----------------')

הדפס (פלט)

הפלט של הקוד לעיל ניתן להלן:

זה הכל מהמדריך הזה. הקישור ל- Google Co מוזכר גם במאמר זה

סיכום

כדי להחיל צינורות על מערך הנתונים, אנו יכולים לחזור על מערך נתונים באמצעות פונקציית pipeline() או להשתמש ב-' מערכי נתונים 'ספרייה. Hugging Face מספק את הקישור למאגר GitHub למשתמשים שלו הן עבור מערכי נתונים והן עבור מודלים שניתן להשתמש בהם בהתבסס על הדרישות. מאמר זה סיפק מדריך מקיף להחלת צינורות על מערך נתונים ב-Transformers.