מדריך זה ימחיש את תהליך השימוש בזיכרון הישות ב-LangChain.

כיצד להשתמש בזיכרון ישות ב-LangChain?

הישות משמשת כדי לשמור את העובדות המרכזיות המאוחסנות בזיכרון כדי לחלץ כאשר האדם מתבקש על ידי השאילתות/ההנחיות. כדי ללמוד את תהליך השימוש בזיכרון הישות ב-LangChain, פשוט בקר במדריך הבא:

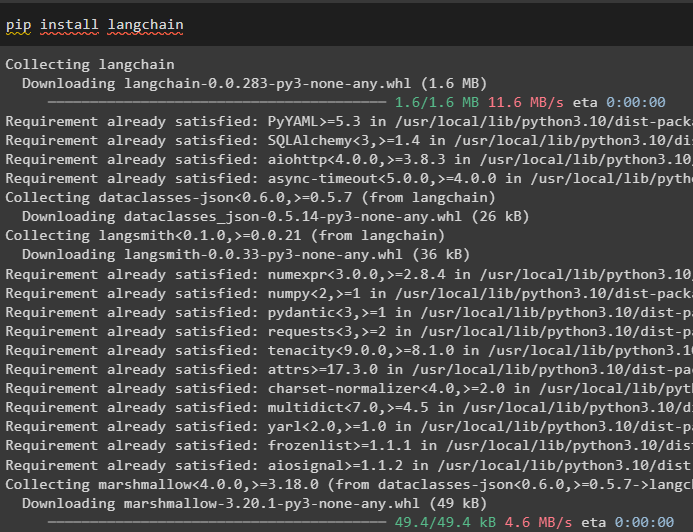

שלב 1: התקן מודולים

ראשית, התקן את מודול LangChain באמצעות פקודת pip כדי לקבל את התלות שלו:

pip להתקין langchain

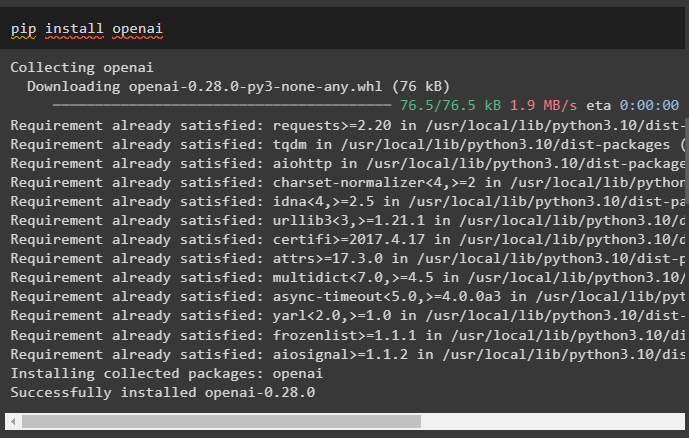

לאחר מכן, התקן את מודול OpenAI כדי לקבל את הספריות שלו לבניית LLMs ומודלים של צ'אט:

pip להתקין openai

הגדר את סביבת OpenAI באמצעות מפתח ה-API שניתן לחלץ מחשבון OpenAI:

יְבוּא אתה

יְבוּא getpass

אתה . בְּעֵרֶך [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'מפתח API של OpenAI:' )

שלב 2: שימוש בזיכרון הישות

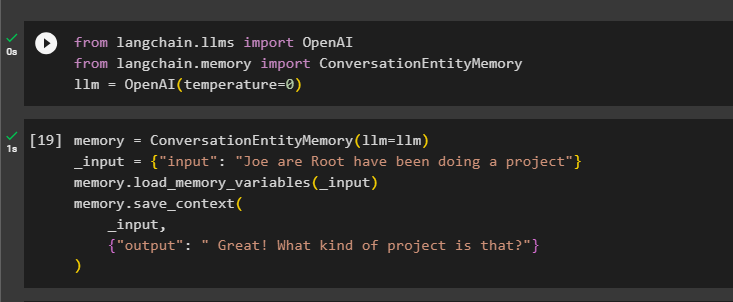

כדי להשתמש בזיכרון הישות, ייבא את הספריות הנדרשות לבניית ה-LLM באמצעות שיטת OpenAI():

מ langchain. llms יְבוּא OpenAIמ langchain. זיכרון יְבוּא ConversationEntityMemory

llm = OpenAI ( טֶמפֶּרָטוּרָה = 0 )

לאחר מכן, הגדר את ה זיכרון משתנה באמצעות שיטת ConversationEntityMemory() כדי לאמן את המודל באמצעות משתני הקלט והפלט:

זיכרון = ConversationEntityMemory ( llm = llm )_קֶלֶט = { 'קֶלֶט' : 'Joe are Root עשו פרויקט' }

זיכרון. load_memory_variables ( _קֶלֶט )

זיכרון. save_context (

_קֶלֶט ,

{ 'תְפוּקָה' : 'נהדר! איזה סוג של פרויקט זה?' }

)

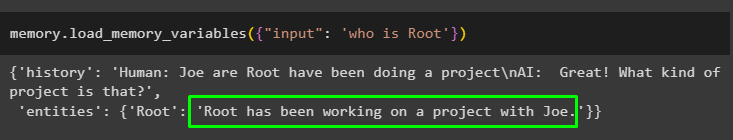

כעת, בדוק את הזיכרון באמצעות השאילתה/הנחיה ב- קֶלֶט משתנה על ידי קריאה לשיטת load_memory_variables():

זיכרון. load_memory_variables ( { 'קֶלֶט' : 'מי זה שורש' } )

כעת, תן קצת יותר מידע כדי שהמודל יוכל להוסיף עוד כמה ישויות בזיכרון:

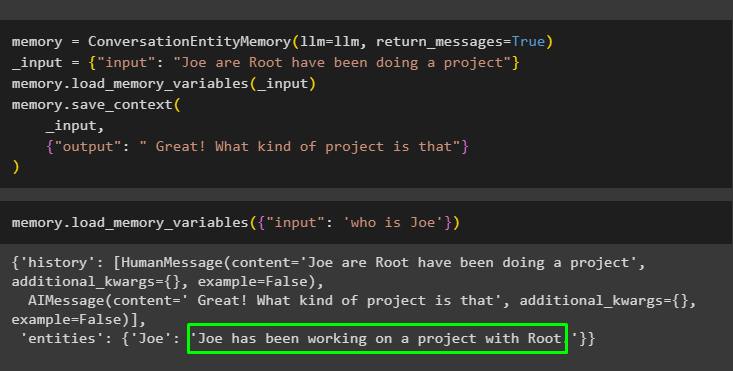

זיכרון = ConversationEntityMemory ( llm = llm , return_messages = נָכוֹן )_קֶלֶט = { 'קֶלֶט' : 'Joe are Root עשו פרויקט' }

זיכרון. load_memory_variables ( _קֶלֶט )

זיכרון. save_context (

_קֶלֶט ,

{ 'תְפוּקָה' : 'נהדר! איזה סוג של פרויקט זה' }

)

בצע את הקוד הבא כדי לקבל את הפלט באמצעות הישויות המאוחסנות בזיכרון. זה אפשרי דרך ה קֶלֶט המכיל את ההנחיה:

זיכרון. load_memory_variables ( { 'קֶלֶט' : 'מי זה ג'ו' } )

שלב 3: שימוש בזיכרון הישות בשרשרת

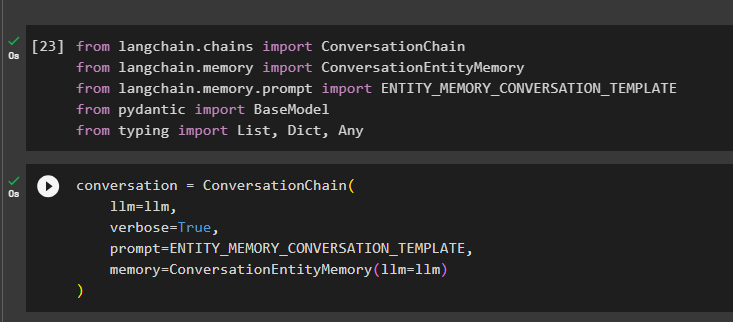

כדי להשתמש בזיכרון הישות לאחר בניית שרשרת, פשוט ייבא את הספריות הנדרשות באמצעות בלוק הקוד הבא:

מ langchain. שרשראות יְבוּא ConversationChainמ langchain. זיכרון יְבוּא ConversationEntityMemory

מ langchain. זיכרון . מיידי יְבוּא ENTITY_MEMORY_CONVERSATION_TEMPLATE

מ פידנטי יְבוּא דגם בסיס

מ הקלדה יְבוּא רשימה , דיקט , כל

בנה את מודל השיחה באמצעות שיטת ConversationChain() באמצעות הארגומנטים כמו llm:

שִׂיחָה = ConversationChain (llm = llm ,

מִלוּלִי = נָכוֹן ,

מיידי = ENTITY_MEMORY_CONVERSATION_TEMPLATE ,

זיכרון = ConversationEntityMemory ( llm = llm )

)

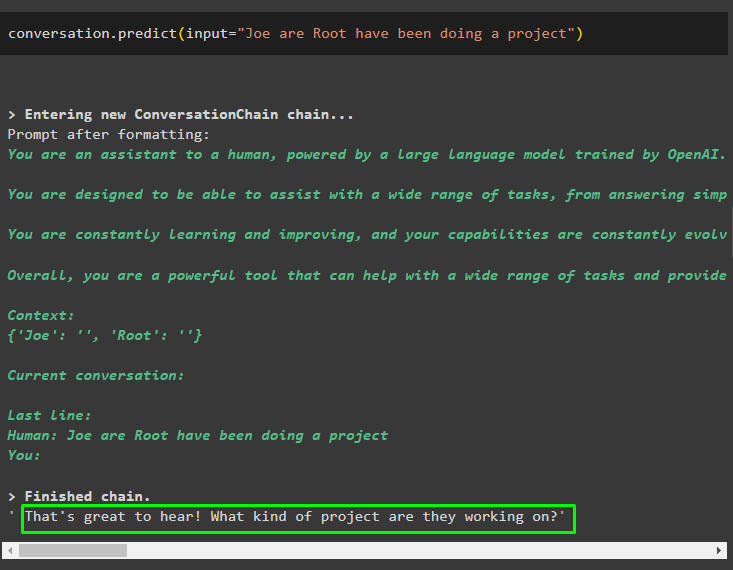

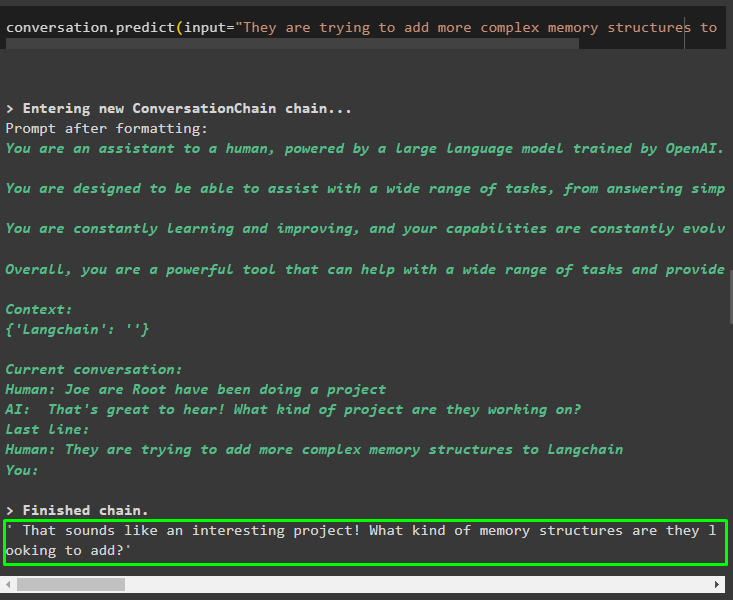

קרא למתודה conversation.predict() כשהקלט מאותחל עם ההנחיה או השאילתה:

שִׂיחָה. לנבא ( קֶלֶט = 'Joe are Root עשו פרויקט' )

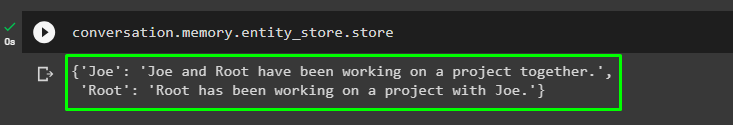

כעת, קבל את הפלט הנפרד עבור כל ישות המתאר את המידע עליה:

שִׂיחָה. זיכרון . חנות_ישות . חנות

השתמש בפלט מהמודל כדי לתת את הקלט כדי שהמודל יוכל לאחסן מידע נוסף על הישויות האלה:

שִׂיחָה. לנבא ( קֶלֶט = 'הם מנסים להוסיף מבני זיכרון מורכבים יותר ל-Langchain' )

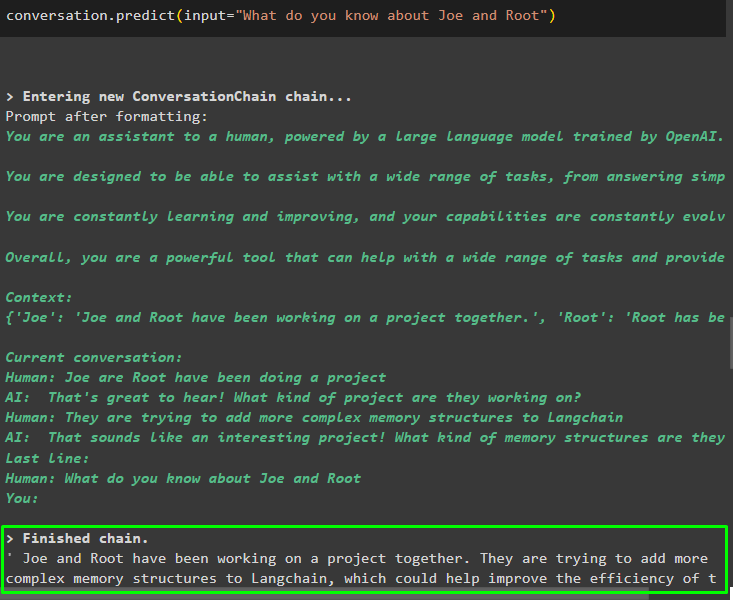

לאחר מתן המידע המאוחסן בזיכרון, פשוט שאל את השאלה כדי לחלץ את המידע הספציפי על ישויות:

שִׂיחָה. לנבא ( קֶלֶט = 'מה אתה יודע על ג'ו ורוט' )

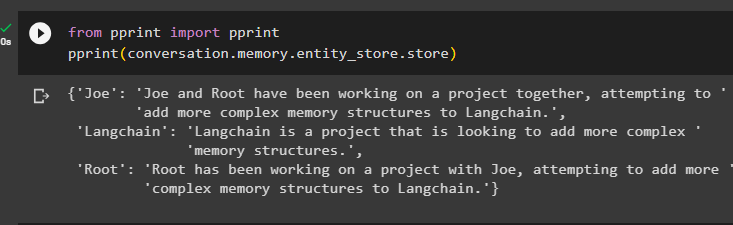

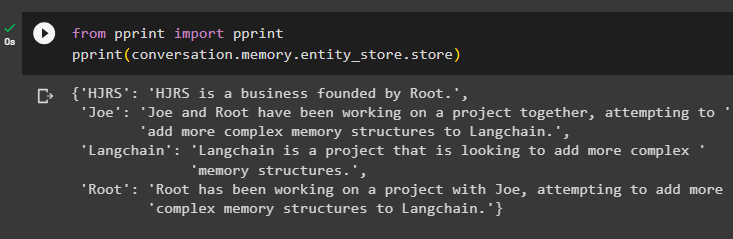

שלב 4: בדיקת מאגר הזיכרון

המשתמש יכול לבדוק את מאגרי הזיכרון ישירות כדי לקבל את המידע המאוחסן בהם באמצעות הקוד הבא:

מ הדפס יְבוּא הדפסהדפס ( שִׂיחָה. זיכרון . חנות_ישות . חנות )

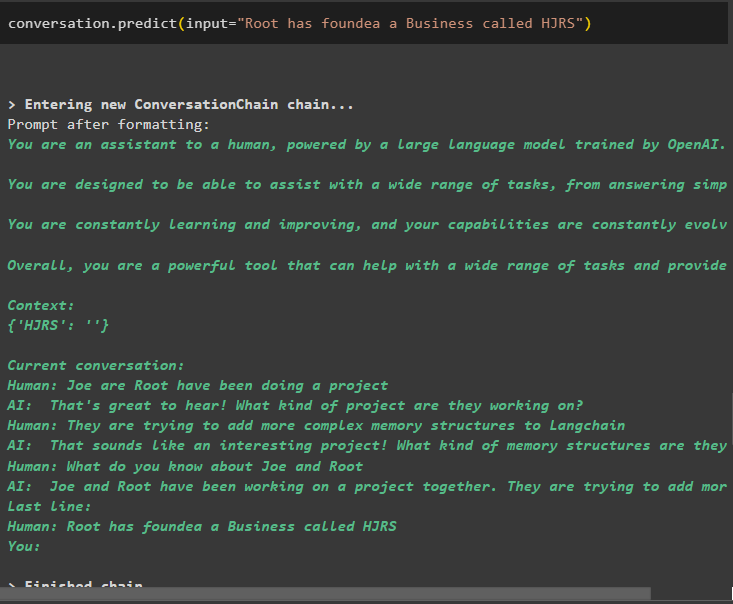

ספק מידע נוסף שיישמר בזיכרון מכיוון שמידע נוסף נותן תוצאות מדויקות יותר:

שִׂיחָה. לנבא ( קֶלֶט = 'שורש הקים עסק בשם HJRS' )

חלץ מידע ממאגר הזיכרון לאחר הוספת מידע נוסף על הישויות:

מ הדפס יְבוּא הדפסהדפס ( שִׂיחָה. זיכרון . חנות_ישות . חנות )

בזיכרון יש מידע על ישויות מרובות כמו HJRS, Joe, LangChain ו-Root:

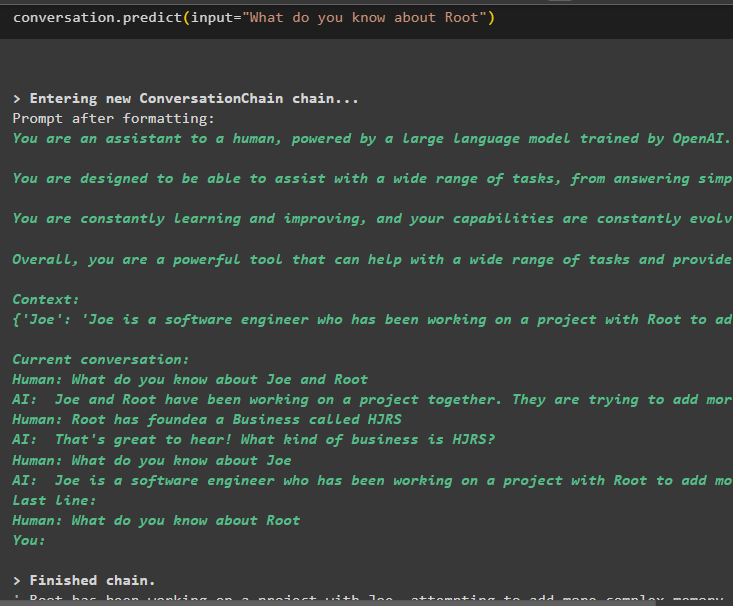

כעת חלץ מידע על ישות ספציפית באמצעות השאילתה או ההנחיה המוגדרים במשתנה הקלט:

שִׂיחָה. לנבא ( קֶלֶט = 'מה אתה יודע על שורש' )

זה הכל על שימוש בזיכרון הישות באמצעות מסגרת LangChain.

סיכום

כדי להשתמש בזיכרון הישות ב-LangChain, פשוט התקן את המודולים הנדרשים לייבוא ספריות הנדרשות לבניית מודלים לאחר הגדרת סביבת OpenAI. לאחר מכן, בנה את מודל ה-LLM ואחסן ישויות בזיכרון על ידי מתן מידע על הישויות. המשתמש יכול גם לחלץ מידע באמצעות הישויות הללו ולבנות את הזיכרונות הללו בשרשראות עם מידע מעורער על ישויות. פוסט זה הרחיב את תהליך השימוש בזיכרון הישות ב-LangChain.