תחביר:

כפי שאנו מכירים את ChatGPT, אנו יודעים שפלטפורמה זו נמצאת בבעלות קהילת ה-Open AI והיא מספקת כלים, ארכיטקטורות, APIs ומספר מסגרות בהן נוכל להשתמש בפריסת היישומים שלנו ומודלים לעיבוד שפה טבעית. Open AI מציעה את ממשקי ה-API שדרכם נוכל להשתמש בכל מודל AI ו-NLP מאומנים מראש מפלטפורמת Open AI ויכולים לגרום להם לעבוד עבור היישומים שלנו כמו, למשל, לתת תחזיות על נתונים בזמן אמת. כמו כן, GPT4All גם מספקת למשתמשים שלה לשלב את דגמי הבינה המלאכותית המאומנים שלה עם יישומים שונים.

מודל GPT4All מאומן על נתונים מוגבלים בהשוואה ל-ChatGPT. יש לו גם כמה מאילוצי הביצועים שלו בהשוואה ל-ChatGPT אבל זה מאפשר למשתמש להשתמש ב-GPT הפרטי שלו בחומרה המקומית שלו וזה לא דורש שום חיבורי רשת. בעזרת מאמר זה נכיר כיצד נוכל להשתמש בדגמי GPT4All בסקריפט של Python שכן ל-GPT4All יש את ה-bindings הרשמיים עם Python מה שאומר שאנו יכולים להשתמש ולשלב את המודלים של GPT4All גם דרך סקריפט Python.

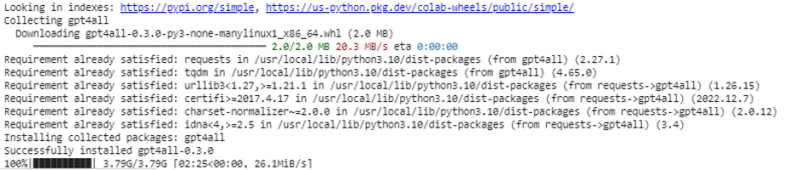

כל זה דורש פקודה מקוונת כדי להתקין את GPT4All עבור Python IDE. לאחר מכן, אנו עשויים לשלב דגמי בינה מלאכותית כמו היישומים שלנו. הפקודה להתקין את ה- GPT4All ב- Python היא כפי שמוצג להלן:

$ pip התקנת gpt4all

דוגמה 1:

כדי להתחיל עם הדוגמה הזו, עלינו להוריד ולהתקין את Python במערכות שלנו. הגרסאות המומלצות של Python הן 'גרסה 3.7' או אלה שהגיעו אחרי גרסה זו. דרך נוספת לעבוד עם Python כדי להימנע מהתהליך הארוך של התקנת 'הגדרת Python' במערכות שלנו היא שימוש ב-'Google Colab' שהיא סביבה מבוססת ענן עבור Python. אנחנו יכולים להפעיל סביבה זו בכל דפדפן אינטרנט ויכולים לבנות את מודלים של AI ולמידת מכונה. הדוגמאות שנטמיע כאן מבוצעות ב-Google Colab.

דוגמה זו מכסה את השיטה להתקנת ה-GPT4All ב-Python וכיצד להשתמש במודלים שהוכשרו מראש שלו. אנו מתחילים בהתקנה תחילה של GPT4All. לשם כך, הפקודה שהזכרנו קודם מבוצעת. עם ביצוע הפקודה, ה-GPT4All יחד עם החבילות והמסגרות שלו מורידים ומותקנים.

עכשיו, אנחנו מתקדמים. מ-GPT4All, אנו מייבאים את ה-'GPT4All'. זה מוסיף את כל הדגמים שהוכשרו מראש מה-GPT4All לפרויקט. כעת, אנו עשויים להשתמש בכל מודל בודד ולגרום לו לבצע את התחזיות עבור היישום שלנו. ברגע שאנו מייבאים את חבילת GPT4All, הגיע הזמן לקרוא לפונקציה זו ולהשתמש במודל GPT4All שנותן את הפלט עבור 'השלמת הצ'אט'.

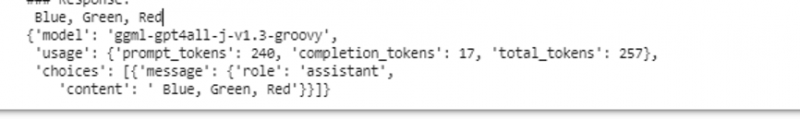

במילים אחרות, אם נבקש משהו מהמודל הזה בקלט, הוא מחזיר אותו בפלט. המודל שבו אנו משתמשים כאן הוא 'ggml-gpt4all-j-v1.3-groovy'. דגמים אלה כבר מאוחסנים במטמון GPT4All. אנחנו יכולים להשיג את הדגמים האלה מהקישור הזה ' https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ' להורדה ידנית. אם המודל כבר קיים במטמון GPT4All, אנו פשוט קוראים לשם המודל ומציינים אותו כפרמטרי קלט לפונקציה 'GPT4All()'. אם הורדנו אותו ידנית בהצלחה, נעביר את הנתיב לתיקיה שבה נמצא הדגם. מכיוון שמודל זה מיועד להשלמת הודעות, התחביר עבור מודל זה ניתן באופן הבא:

$ Chat_completion (הודעות)ההודעות הן רשימת מילון וכל מילון צריך להכיל מפתח 'תפקיד' עם ערך של המשתמש, המערכת או העוזר, ותוכן ה'מפתח' בעל הערך כמחרוזת. בדוגמה זו, אנו מציינים את התוכן כ'שם שלושה צבעים' ואת מפתח התפקיד כ'משתמש'.

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'role': 'משתמש', 'content': 'שם 3 פרחים'}]

לאחר מפרט זה, אנו קוראים לפונקציה 'chat_completion()' עם המודל. הקוד לכך מוצג בפלט הבא:

$ !pip התקנת gpt4allמ-gpt4all ייבוא GPT4All

model = GPT4All('ggml-gpt4all-j-v1.3-groovy')

messages = [{'role': 'user', 'content': 'שם שלושה צבעים'}]

model.chat_completion(messages)

לאחר ביצוע הדוגמה הזו, המודל מחזיר שלושה צבעים כתגובה לקלט.

דוגמה 2:

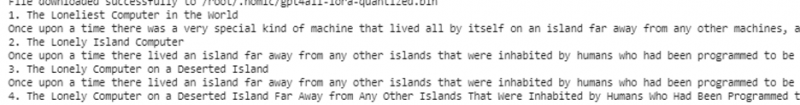

אנו מכסים דוגמה נוספת שבה אנו מגלים שיטה נוספת להשתמש ב- GPT4All ב- Python. ניתן לעשות זאת באמצעות הכריכות הרשמיות עבור ה-Python אשר מסופק על ידי 'Nomic' שהיא קהילת AI בקוד פתוח, והיא מריץ את GPT4All. באמצעות הפקודה הבאה, אנו משלבים 'nomic' בקונסולת Python שלנו:

$ pip התקנת nomicלאחר ההתקנה, אנו מייבאים את ה-GPT4All מ-'nomic.gpt4all'. לאחר ייבוא GPT4All, אנו מאתחלים את GPT4All עם הפונקציה 'open()'. לאחר מכן, אנו קוראים לפונקציה 'prompt()' ומעבירים הנחיה לפונקציה זו. לאחר מכן, נוצרת תגובה מהירה על סמך ההנחיה שנתנו כקלט למודל ההנחיה.

!pip התקן את nomicמאת nomic.gpt4all ייבוא GPT4All

# אתחול מודל GPT4All

initiate = GPT4All()

initiate.open()

# יצירת תגובה על סמך ההנחיה

model_response = initiate.prompt('כתוב סיפור קצר על מחשב)

# הצגת התגובה שנוצרה

print(model_response)

הפלט מציג את התגובה המהירה מהמודל שיצרנו באמצעות מודל GPT4All המאומן מראש ב- Python. אם ברצוננו לדעת יותר על המודלים וכיצד אנו יכולים להשתמש במודלים אלה כדי ליצור את התגובות, או במילים פשוטות, אם ברצוננו לקבל ידע על התחביר ליצירת התגובות מהמודלים הללו, אנו עשויים לקחת עזרה נוספת מה- פרטי התיעוד הטכני של GPT4All.

סיכום

GPT4All עדיין שואפת להשיג דיוק ביצועים. היא מנוהלת על ידי פלטפורמת הבינה המלאכותית הנומית שמטרתה לספק צ'אטבוטים אינטליגנטיים באופן מלאכותי למשתמשים שלה במעבדים בדרגת צרכן מכיוון ש-GPT4All עובד ללא כל חיבור רשת ו-GPUs. מאמר זה מאיר אותנו להשתמש במיומנות ב- PyGPT4All בסביבת Python וליצור אינטראקציה בין היישומים שלנו לבין דגמי הבינה המלאכותית של GPT4All שהוכשרו מראש. כיסינו שתי שיטות שונות כיצד להתקין GPT4All ב-Python במדריך זה.