מדריך זה ימחיש את תהליך השימוש בגרף ידע השיחה ב-LangChain.

כיצד להשתמש ב-Conversation Knowledge Graph ב-LangChain?

ה שיחהKGMזיכרון ניתן להשתמש בספרייה כדי ליצור מחדש את הזיכרון שניתן להשתמש בו כדי לקבל את ההקשר של האינטראקציה. כדי ללמוד את תהליך השימוש בגרף ידע השיחה ב-LangChain, פשוט עברו על השלבים המפורטים:

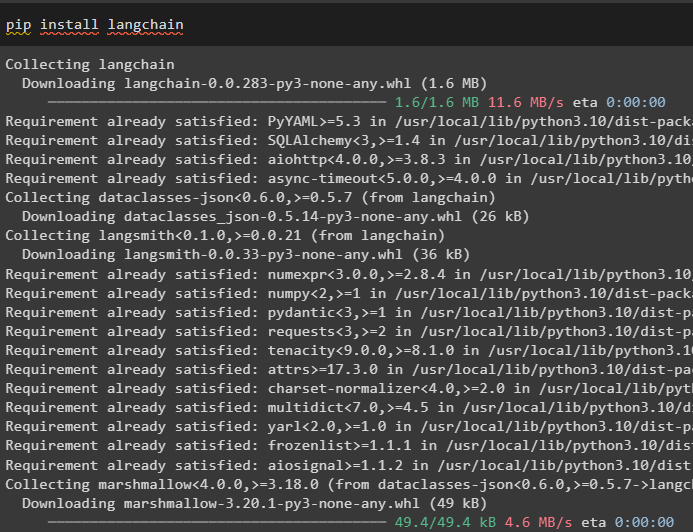

שלב 1: התקן מודולים

ראשית, התחל עם תהליך השימוש בגרף ידע השיחה על ידי התקנת מודול LangChain:

pip להתקין langchain

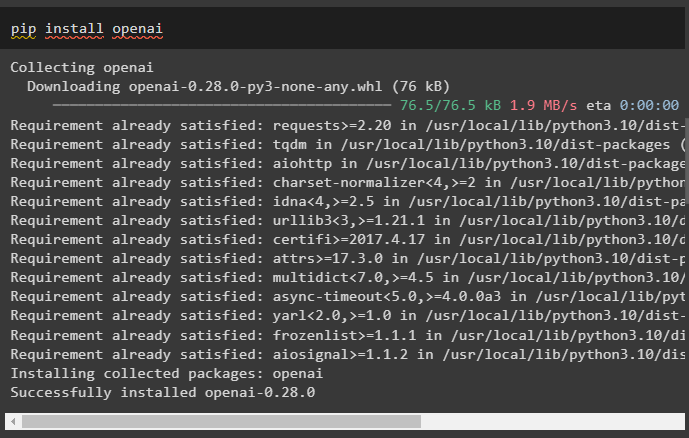

התקן את מודול OpenAI שניתן להתקין באמצעות פקודת pip כדי לקבל את הספריות שלו לבניית דגמי שפה גדולים:

pip להתקין openai

עַכשָׁיו, להקים את הסביבה באמצעות מפתח OpenAI API שניתן להפיק מהחשבון שלו:

יְבוּא אתה

יְבוּא getpass

אתה . בְּעֵרֶך [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'מפתח API של OpenAI:' )

שלב 2: שימוש בזיכרון עם LLMs

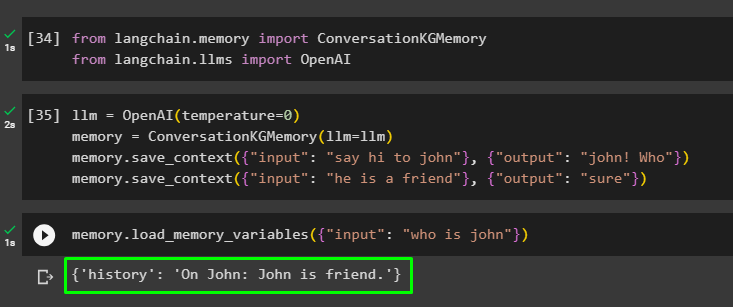

לאחר התקנת המודולים, התחל להשתמש בזיכרון עם LLM על ידי ייבוא הספריות הנדרשות ממודול LangChain:

מ langchain. זיכרון יְבוּא שיחהKGMזיכרוןמ langchain. llms יְבוּא OpenAI

בנה את ה-LLM בשיטת OpenAI() והגדר את הזיכרון באמצעות ה- שיחהKGMזיכרון () שיטה. לאחר מכן, שמור את תבניות ההנחיות באמצעות מספר כניסות עם התגובה שלהן כדי לאמן את המודל על נתונים אלה:

llm = OpenAI ( טֶמפֶּרָטוּרָה = 0 )זיכרון = שיחהKGMזיכרון ( llm = llm )

זיכרון. save_context ( { 'קֶלֶט' : 'תגיד שלום לג'ון' } , { 'תְפוּקָה' : 'ג'ון! מי' } )

זיכרון. save_context ( { 'קֶלֶט' : 'הוא חבר' } , { 'תְפוּקָה' : 'בטוח' } )

בדוק את הזיכרון על ידי טעינת ה- זיכרון_משתני () שיטה המשתמשת בשאילתה הקשורה לנתונים שלעיל:

זיכרון. load_memory_variables ( { 'קֶלֶט' : 'מי זה ג'ון' } )

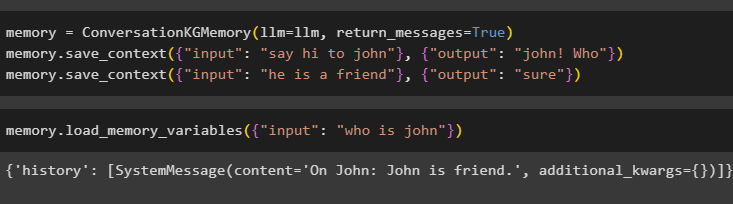

הגדר את הזיכרון באמצעות שיטת ConversationKGMemory() עם ה- return_messages טיעון כדי לקבל גם את ההיסטוריה של הקלט:

זיכרון = שיחהKGMזיכרון ( llm = llm , return_messages = נָכוֹן )זיכרון. save_context ( { 'קֶלֶט' : 'תגיד שלום לג'ון' } , { 'תְפוּקָה' : 'ג'ון! מי' } )

זיכרון. save_context ( { 'קֶלֶט' : 'הוא חבר' } , { 'תְפוּקָה' : 'בטוח' } )

פשוט בדוק את הזיכרון על ידי מתן ארגומנט הקלט עם הערך שלו בצורה של שאילתה:

זיכרון. load_memory_variables ( { 'קֶלֶט' : 'מי זה ג'ון' } )

כעת, בדוק את הזיכרון על ידי שאילת השאלה שאינה מוזכרת בנתוני האימון, ולמודל אין מושג לגבי התגובה:

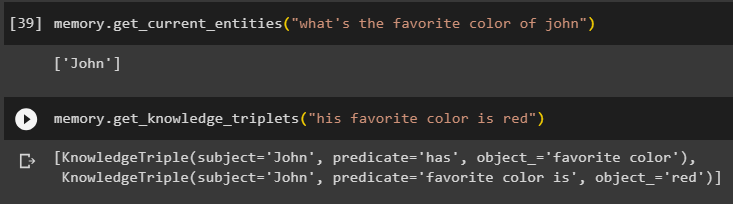

זיכרון. get_current_entities ( 'מה הצבע האהוב על ג'ון' )להשתמש ב get_knowledge_triplets שיטת () על ידי תגובה לשאילתה שנשאלה קודם לכן:

זיכרון. get_knowledge_triplets ( 'הצבע האהוב עליו הוא אדום' )

שלב 3: שימוש בזיכרון בשרשרת

השלב הבא משתמש בזיכרון השיחה עם הרשתות כדי לבנות את מודל ה-LLM בשיטת OpenAI(). לאחר מכן, הגדר את תבנית ההנחיה באמצעות מבנה השיחה והטקסט יוצג תוך קבלת הפלט על ידי המודל:

llm = OpenAI ( טֶמפֶּרָטוּרָה = 0 )מ langchain. הנחיות . מיידי יְבוּא PromptTemplate

מ langchain. שרשראות יְבוּא ConversationChain

תבנית = '''זו התבנית לאינטראקציה בין אדם למכונה

המערכת היא מודל AI שיכול לדבר או לחלץ מידע על היבטים מרובים

אם הוא לא מבין את השאלה או שיש לו את התשובה, הוא פשוט אומר זאת

המערכת מחלצת נתונים המאוחסנים בסעיף 'ספציפי' ואינה הוזה

ספֵּצִיפִי:

{הִיסטוֹרִיָה}

שִׂיחָה:

אנושי: {קלט}

AI:'''

#הגדר את התבנית או המבנה למתן הנחיות וקבלת תגובה ממערכת הבינה המלאכותית

מיידי = PromptTemplate ( משתני_קלט = [ 'הִיסטוֹרִיָה' , 'קֶלֶט' ] , תבנית = תבנית )

שיחה_עם_ק'ג = ConversationChain (

llm = llm , מִלוּלִי = נָכוֹן , מיידי = מיידי , זיכרון = שיחהKGMזיכרון ( llm = llm )

)

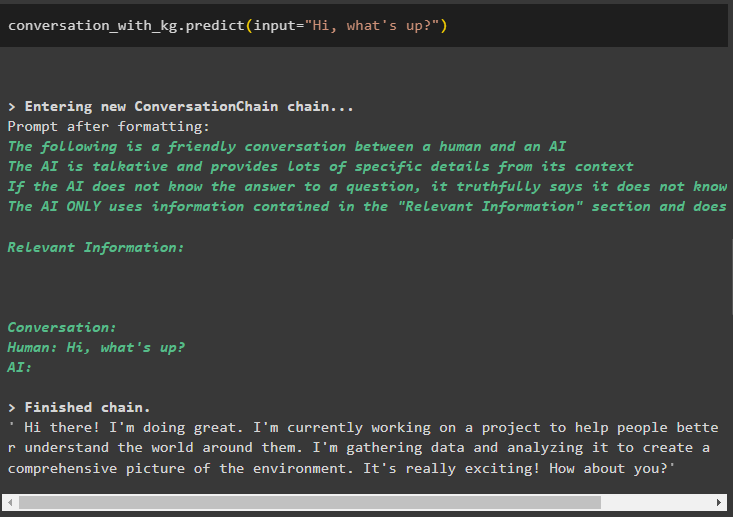

לאחר יצירת המודל, פשוט התקשר ל- שיחה_עם_ק'ג מודל באמצעות שיטת predict() עם השאילתה שנשאלה על ידי המשתמש:

שיחה_עם_ק'ג. לנבא ( קֶלֶט = 'היי מה קורה?' )

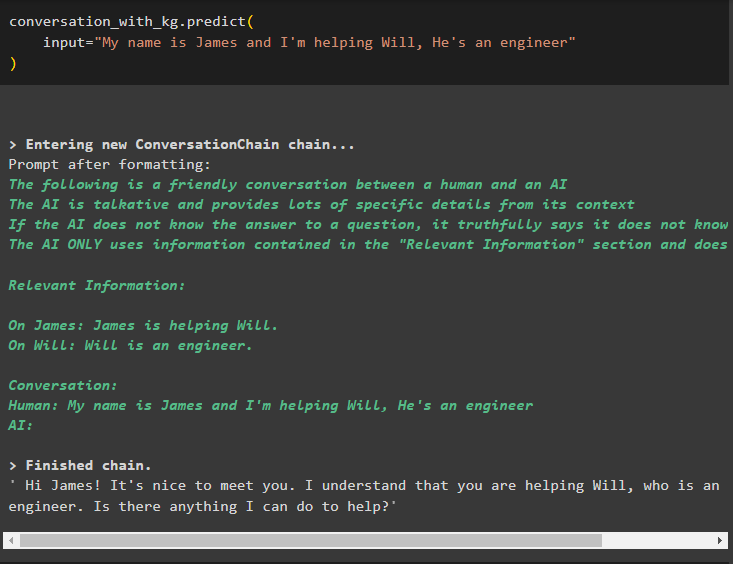

כעת, אמנו את המודל באמצעות זיכרון שיחה על ידי מתן המידע כארגומנט הקלט עבור השיטה:

שיחה_עם_ק'ג. לנבא (קֶלֶט = 'שמי ג'יימס ואני עוזר לוויל, הוא מהנדס'

)

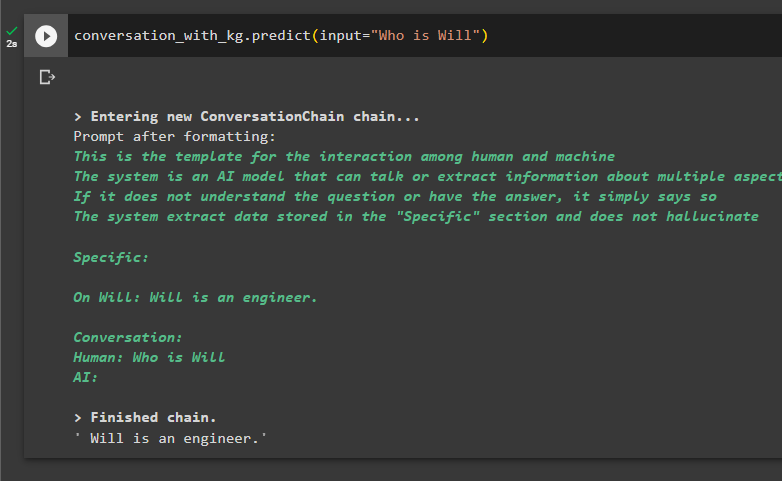

זה הזמן לבדוק את המודל על ידי בקשת השאילתות לחלץ מידע מהנתונים:

שיחה_עם_ק'ג. לנבא ( קֶלֶט = 'מי זה וויל' )

זה הכל על שימוש בגרף ידע השיחה ב-LangChain.

סיכום

כדי להשתמש בגרף ידע השיחה ב-LangChain, התקן את המודולים או המסגרות לייבא ספריות לשימוש בשיטת ConversationKGMemory(). לאחר מכן, בנה את המודל באמצעות הזיכרון כדי לבנות את השרשראות ולחלץ מידע מנתוני האימון שסופקו בתצורה. מדריך זה הרחיב את תהליך השימוש בגרף ידע השיחה ב-LangChain.