בבלוג זה נתמקד בדרכים שבהן תוכל להגביר את ניצול ה-GPU ב-PyTorch.

כיצד להגדיל את ניצול ה-GPU ב- PyTorch?

ישנן מספר טכניקות שניתן להשתמש בהן כדי להגביר את ניצול ה-GPU ולהבטיח כי נעשה שימוש במשאבי החומרה הטובים ביותר לעיבוד מודלים מורכבים של למידת מכונה. טקטיקות אלו כוללות עריכת הקוד ושימוש בתכונות PyTorch. כמה טיפים וטריקים חשובים מפורטים להלן:

- טעינת נתונים וגדלים אצווה

- דגמים פחות תלויי זיכרון

- PyTorch Lightning

- התאם את הגדרות זמן הריצה ב-Google Colab

- נקה מטמון לאופטימיזציה

טעינת נתונים וגדלים אצווה

ה ' טוען נתונים ” ב- PyTorch משמש להגדרת המפרט של הנתונים שיועלו למעבד בכל מעבר קדימה של מודל הלמידה העמוקה. גדול יותר ' גודל אצווה ' של נתונים ידרוש כוח עיבוד רב יותר ויגדיל את הניצול של ה-GPU הזמין.

התחביר להקצאת Dataloader עם גודל אצווה ספציפי ב- PyTorch למשתנה מותאם אישית ניתן להלן:

Increase_GPU_Utilization = DataLoader ( גודל_אצווה = 32 )

דגמים פחות תלויי זיכרון

כל ארכיטקטורת דגם דורשת נפח שונה של ' זיכרון 'לבצע ברמתו האופטימלית. מודלים יעילים בשימוש בפחות זיכרון ליחידת זמן מסוגלים לעבוד עם גדלי אצווה גדולים בהרבה מזה של אחרים.

PyTorch Lightning

ל- PyTorch יש גרסה מוקטנת שהיא ' PyTorch Lightning '. הוא מותאם לביצועים מהירים בזק כפי שניתן לראות משמו. Lightning משתמש ב-GPU כברירת מחדל ומציע עיבוד מהיר הרבה יותר עבור מודלים של למידת מכונה. יתרון עיקרי של Lightning הוא היעדר הדרישה לקוד לוחית שעלול להפריע לעיבוד.

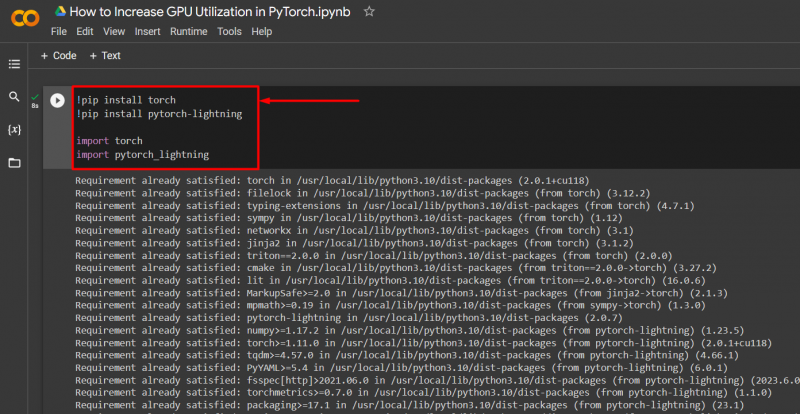

ייבא את הספריות הדרושות לפרויקט PyTorch עם התחביר המופיע להלן:

! לפיד להתקין pip

! pip התקנת pytorch - בָּרָק

יְבוּא לפיד

יְבוּא pytorch_lightning

התאם את הגדרות זמן הריצה ב-Google Colab

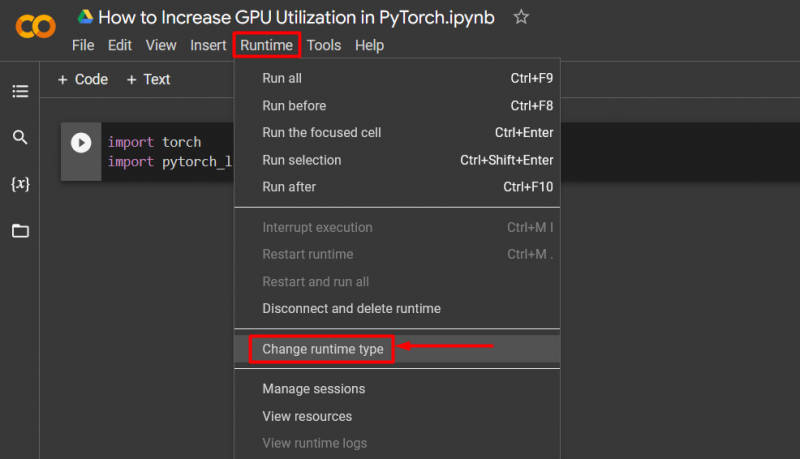

Google Collaboratory הוא IDE בענן המספק גישת GPU בחינם למשתמשים שלו לפיתוח דגמי PyTorch. כברירת מחדל, הפרויקטים של Colab פועלים על CPU אך ניתן לשנות את ההגדרות.

פתח את המחברת של Colab, עבור אל ' זמן ריצה אפשרות ' בשורת התפריטים, וגלול מטה אל ' שנה הגדרות זמן ריצה ”:

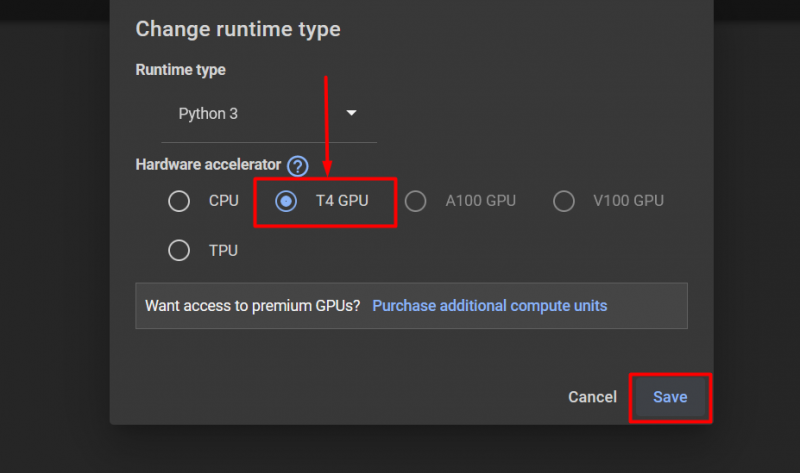

לאחר מכן, בחר את 'GPU T4' אפשרות ולחץ על ' להציל כדי להחיל את השינויים לשימוש ב-GPU:

נקה מטמון לאופטימיזציה

PyTorch מאפשרת למשתמשים שלה לנקות את מטמון הזיכרון על מנת שיוכלו לפנות מקום לתהליכים חדשים לרוץ. ה ' מטמון ” מאחסן נתונים ומידע על המודלים המופעלים כך שהוא יכול לחסוך זמן שיושקע בטעינה מחדש של מודלים אלו. ניקוי המטמון מספק למשתמשים יותר מקום להפעיל דגמים חדשים.

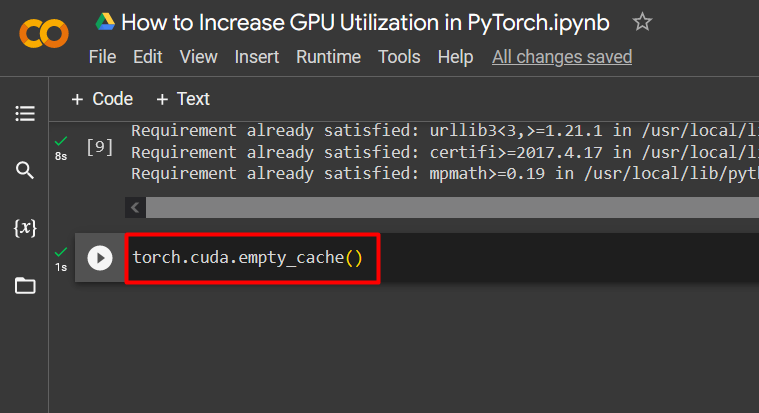

הפקודה לנקות את מטמון ה-GPU ניתנת להלן:

לפיד. שונה . מטמון_ריק ( )

טיפים אלה משמשים כדי לייעל את ההפעלה של מודלים של למידת מכונה עם GPUs ב- PyTorch.

פרו-טיפ

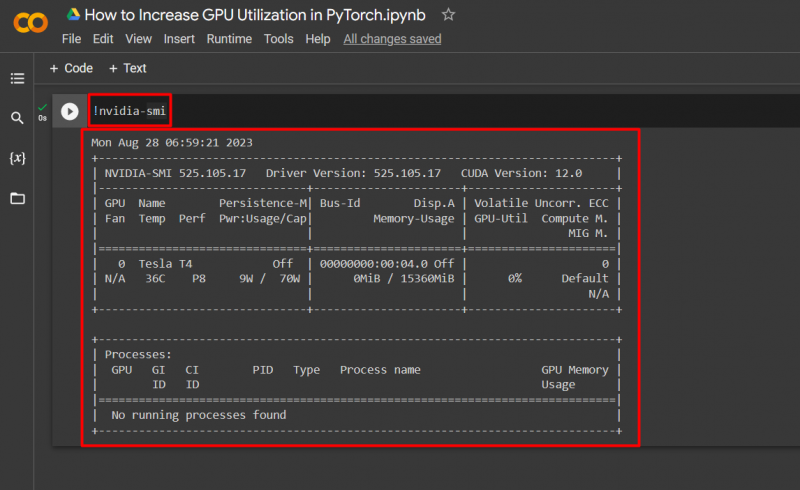

Google Colab מאפשרת למשתמשים שלה לגשת לפרטים על ניצול GPU על ידי ' nvidia 'כדי לקבל מידע על היכן מנוצלים משאבי החומרה. הפקודה להצגת פרטי השימוש ב-GPU ניתנת להלן:

! nvidia - סמי

הַצלָחָה! זה עתה הדגמנו כמה דרכים להגביר את ניצול ה-GPU ב-PyTorch.

סיכום

הגדל את ניצול ה-GPU ב- PyTorch על ידי מחיקת מטמון, שימוש ב- PyTorch Lightning, התאמת הגדרות זמן ריצה, שימוש במודלים יעילים וגדלים אופטימליים של אצווה. טכניקות אלו מבטיחות שמודלים של למידה עמוקה מתפקדים במיטבם ומסוגלים להסיק מסקנות והסקות תקפות מהנתונים הזמינים. הדגמנו את הטכניקות להגברת ניצול ה-GPU.